Télécharger l’article en PDF : ![]()

Dans son célèbre ouvrage « De l’esprit des lois » publié au 18e siècle, Montesquieu théorisa suivant trois axes la répartition et la séparation des pouvoirs de l’état avec le législatif, l’exécutif et le judiciaire.

Ultérieurement, un quatrième pouvoir concernant les moyens de communications au sens large ou médias de masses dits « Mainstream » fut ajouté à la liste du fait, dans le cadre d’un régime démocratique, de son énorme influence sur les électeurs.

A l’heure où en occident une oligarchie financière systémique et sans visage a réussit à prendre le quasi contrôle de tous ces pouvoirs, il est nécessaire de comprendre qui elle est ainsi que ses modes de fonctionnement afin d’appliquer l’un des célèbres adages de Sun Tzu :

« Pour vaincre l’ennemi, il faut connaitre l’ennemi ! »

L’objectif pour les peuples est ambitieux, il s’agit de remettre le diable dans sa boite en passant par l’étape incontournable d’une prise de conscience massive des cerveaux.

Ces derniers sont aujourd’hui, comme l’ont dénoncé par exemple Bourdieu [1] ou Chomsky [2], largement sous contrôle de l’influence télévisuelle et plus généralement des médias « Mainstream » encore appelés « MSM » (*) devenus l’un des bras armés de l’oligarchie.

(*) MainStream Médias

L’oligarchie est constituée d’une minorité d’individus qui concentre entre ses mains une part majeure des richesses mondiales.

Que sait on au juste sur cette dernière et sur ses modes d’action ?

Géopolitique, oligarchie et état profond

La situation actuelle est la résultante d’une généalogie événementielle dont les origines remontent à 1945 lors du partage du monde entre l’est et l’ouest durant la conférence de Yalta.

A la fin de la seconde guerre mondiale lors des négociations de Yalta entre les vainqueurs russes, américains et britanniques, le monde fut divisé en deux blocs avec d’un coté le bloc-BAO pour « Bloc Américano Occidental » et de l’autre le bloc soviétique constitué de l’URSS et des pays limitrophes d’Europe de l’est.

Dans le domaine financier, le système monétaire mondial fut basé sur l’hégémonie du dollar américain avec les accords de Bretton Woods ayant conduit à la création de deux institutions d’obédience occidentale : la Banque Mondiale (BM) et le Fond Monétaire International (FMI).

L’ONU fut également créée à cette époque afin de donner un cadre législatif au droit international ainsi qu’une tribune mondiale permettant de prévenir les conflits par le dialogue.

Cette situation perdura durant un demi siècle jusqu’à la disparition endogène du bloc soviétique en 1991, les États-Unis devinrent durant un temps les leaders d’un monde unipolaire.

Cependant, au début du 21e siècle la progression fulgurante de la Chine puis le retour de la Russie (*) sous l’action très efficace de Vladimir Poutine mirent fin assez rapidement à cette hégémonie.

(*) Après un début de pillage du pays sur le cadavre de l’URSS durant les années 1990.

Ces deux nouvelles superpuissances, économique pour la Chine et militaire pour la Russie, conduisirent à la création du bloc économique BRICS (Brésil, Russie, Inde, Chine, Afrique du Sud) et surtout de l’Organisation de Coopération de Shanghai (OCS) trop méconnue en occident.

Ces deux institutions associées à la création de la banque des BRICS sont complètement indépendantes de leurs concurrentes du monde occidental.

Nous sommes entrés aujourd’hui dans une situation multipolaire avec le bloc BAO constitué de deux pôles économiques que sont les USA et l’Europe de l’ouest et en face le bloc BRICS dominé par le couple Chine-Russie.

Économiquement parlant, américains et européens sont dans une situation critique avec leurs déficits chroniques induisant des montagnes de dettes contrairement aux BRICS créanciers de ces derniers et dont le PIB va bientôt dépasser celui du bloc BAO [3].

A l’heure où un rapprochement économique alternatif se fait à travers l’OCS, le bloc BAO est non seulement en concurrence avec les puissances émergentes mais également en interne. En effet, les USA mènent une guerre économique sans merci à leurs vassaux européens comme l’avait reconnu François Mitterrand peu de temps avant sa disparition.

Pour comprendre le cas américain, il faut avoir à l’esprit quels sont les véritables centres de pouvoir dans ce pays.

Hormis le pouvoir politique exécutif, soit le président des États-Unis et le congrès, on distingue d’abord au sommet de la pyramide la fameuse oligarchie financière mondialisée constituée de ceux qui détiennent les capitaux, à savoir les actionnaires des entreprises multinationales par ailleurs en concurrences entres elles, ce sont les fameux 1% qui détiennent plus de richesses que les 99% restants.

Le seul objectif de cette dernière est de s’enrichir toujours plus quel qu’en soit le moyen et quelles qu’en soient les conséquences, en premier lieu au détriment des salariés qui produisent les richesses par leur travail et en second lieu en minimisant les contributions fiscales et sociales.

Cependant, l’oligarchie n’est pas seule car il existe un second pôle de pouvoir majoritairement basé aux États-Unis appelé « État profond » (Deep State) sur lequel il est indispensable d’attirer l’attention.

Tout commence lorsque les élites américaines se mirent à croire en leur « destinée manifeste« , ces dernières considérèrent alors non sans hybris que ce pays était le dépositaire d’une mission divine pour répandre -de préférence par la force- la « démocratie à l’américaine » sur toute la planète.

L’état profond est une sorte de marécage ténébreux et méphitique où grouille une faune gluante et vénéneuse de psychopathes dont l’objectif est de prendre le contrôle de toutes les ressources de la planète et accessoirement d’imposer son mode de vie. Pour ce faire, ils comptent sur une suprématie militaire qu’ils tentent de conserver à coups de milliards de dollars.

L’identification rigoureuse de ses composants est assez complexe dans la mesure où ce dernier, sans se mettre lui même en avant, use de toute son influence pour imposer sa politique hégémonique à l’exécutif.

L’un de ses constituants majeurs évident concerne le complexe militaro-industriel. Le président Eisenhower avait annoncé en 1961 dans son discours de fin de mandat le risque que ce dernier devienne une entité autonome hors de tout contrôle démocratique.

C’est aujourd’hui et depuis longtemps chose faite.

Avec un budget de la défense d’environ 600 Milliards comparable au PIB de la Suisse, le niveau de puissance correspondant est en théorie vertigineux.

Associé à ce complexe, on trouve l’establishment et autres neocons’ avec la frange historique des tenants de la destinée manifeste des États-Unis.

Cet ensemble est complété par les différentes agences de renseignement avec en tête la CIA dont les crimes majeurs commis contre des états « non amis » ne sont plus à démontrer. Comme l’a révélé Edward Snowden, la NSA quand à elle est chargée d’espionner la planète entière, alliés compris…

Citons enfin l’influence exogène considérable du lobby israélien AIPAC (CRIF en France) sur la politique étrangère américaine au Moyen-Orient où tous les coups sont permis.

L’oligarchie et l’état profond constituent un ensemble bipolaire aux intérêts parfois divergents. Sa principale caractéristique est de rester le plus discret possible et de faire agir à sa place ceux qui détiennent le pouvoir politique dit « démocratique » en utilisant la MSM comme porte-voix.

La technique de contrôle utilisée est des plus simple, elle consiste à utiliser tous les moyens possibles pour influencer l’exécutif et l’opinion publique, que ce soit par exemple à travers le lobbying ou avec le rachat massif des médias de masse.

L’élection de Trump malgré l’opposition de 95% des médias et les sondages fut un énorme échec pour l’élite.

La folle belliqueuse Hillary Clinton, championne de l’oligarchie US et de l’état profond fut battue à plate-couture par cet industriel milliardaire, certes assez fruste mais plus préoccupé par la réindustrialisation du pays et par la détente avec la Russie que par la spéculation financière et les guerres d’ingérences sans fin.

Nous assistons depuis cette élection à une quasi guerre civile sans merci entre l’administration Trump et ce fameux état profond qui cherche à l’éliminer ou à minima à le soumettre.

Le résultat est que l’on arrive plus très bien à comprendrez qui gouverne dans ce pays comme on peut l’observer à travers une politique étrangère versatile et contradictoire.

Remarquons en particulier que le financement de l’énorme machine de guerre US est de plus en plus difficilement assuré par un état surendetté qui -cette fois sur ordre de l’oligarchie- supprime l’impôt à tout va et taille sans vergogne dans les dépenses sociales.

Ce contexte explique également la violence mise dans les tentatives de destruction du bloc BRICS [3] des insoumis d’en face -et de ses alliés tels que l’Iran ou la Syrie- qui œuvre par ailleurs à se libérer au plus vite des chaines du dollar, l’un des derniers vecteurs d’une puissance américaine sur le déclin.

La chute du billet vert signera la fin définitive de ce qui reste de la puissance impériale, elle ne pourra plus vivre au dessus de ses moyens en faisant marcher la planche à billets et en exportant son inflation.

Venons en maintenant au système de mise sous tutelle des pouvoirs politiques par l’oligarchie.

Un système de pouvoir en poupées russes

Régis Chamagne a décrit le système de pouvoir dans les pseudo démocraties occidentales organisé suivant des cercles concentriques [4].

Au centre, on trouve bien entendu l’oligarchie, ce ramassis de ploutocrates constituée des actionnaires, banques et autres multinationales.

Le dominium mundi de cette dernière est basé sur une convergence d’intérêts adossée à une idéologie commune : libre échange, ultra-libéralisme, mondialisation, affaiblissement des états, etc .

L’oligarchie ne possède pas d’organisation pyramidale, elle serait plutôt de type « rhizomatique » (*) car les individus importent peu. Il existe cependant plusieurs instances officieuses d’échanges et de rencontres périodiques telles que le Bilderberg ou la Trilatérale.

(*) Structure horizontale dénuée de niveaux hiérarchiques.

Le second cercle qui entoure et protège le premier est constitué de la classe politique au pouvoir associée à la MSM inféodée au premier cercle qui en sont d’ailleurs les propriétaires [5] [6].

Le troisième cercle comprend l’armée et la police aux ordres du pouvoir politique dont le rôle est la protection du second cercle.

Et enfin, le cercle extérieur est constitué de la population où tout est fait pour qu’elle se tienne tranquille et ne remette pas en cause l’hégémonie des différentes strates du pouvoir.

La puissance potentielle des états forts et non alignés reste cependant un danger pour l’oligarchie.

Cette dernière a aujourd’hui mis en place deux mécanismes de contrôle, ces derniers furent durant un temps limités à l’Europe occidentale mais leur vocation est de s’étendre sans limites :

1) Contrôle économique avec l’UE (Union Européenne)

2) Contrôle militaire avec l’OTAN

Citons également l’anomalie de la gestion privée de la monnaie à travers la privatisation de la FED en 1910 avec le « complot » de l’ile Jekyll.

La partie du monde non alignée (Chine, Russie, certaines nations arabes, etc) avec le bloc BAO fait partie des ennemis à intégrer ou à défaut à détruire. Cette assertion explique la majeure partie des conflits économiques ou géopolitiques que l’on constate aujourd’hui sur la planète comme par exemple en Syrie et en Ukraine.

Coté européen, l’oligarchie avec la complicité de la classe politique [7] a usé de toute son influence pour jeter l’Europe de l’ouest sous la coupe d’institutions supra-nationales à la botte des États-Unis à travers ce qu’Annie Lacroix-Riz a nommé le « Carcan de l’Union Européenne » [8].

L’Amérique possède aussi une arme de destruction massive de ses concurrents économiques à travers l’extraterritorialité du droit US basé sur l’utilisation mondiale du dollar (*) et une institution scélérate dénommée « Advocacy Center« .

(*) Voir en particulier le scandale Alstom où l’état a laissé passer sous contrôle américain une partie de notre industrie nucléaire de défense [9] (résumé ici).

Paradoxe remarquable, le président des États-Unis étant en quasi guerre civile avec l’état profond, ce sont les européistes qui sont maintenant les premiers défenseurs de l’idéologie de ce dernier !

Les dernières élections françaises ont d’ailleurs donné des sueurs froides à l’oligarchie avec le risque d’échec de leur factotum local, cependant tout s’est bien terminé avec la victoire de l’exécutant Macron [10].

Autre paradoxe, la petite Grande Bretagne sortante de l’UE avec son Brexit est devenue le chef de file du bloc BAO dans sa mesquine politique de diabolisation de la Russie (*) pour cause de « trumpisme » pas vraiment aligné avec cette dernière.

(*) Voir par exemple l’affaire Skripal ou les récentes frappes imbéciles contre la Syrie basées sur des fake news.

L’organisation OTAN, émanation obsolète de la guerre froide avec l’URSS est devenue un outil de vassalisation militaire des USA vis à vis des nations d’Europe de l’ouest avec son extension jusqu’aux frontières de la Russie, violant ainsi la parole donnée à cette dernière.

Pour cornaquer les masses populaires, la première phase consistait à prendre le contrôle des médias, c’est chose faite [5][6].

La seconde phase consistait à mettre au point une rhétorique matraquée par ces derniers afin de masquer un totalitarisme qui ne dit pas son nom.

Coup de chance, cette rhétorique existait déjà pour avoir été développée dans le cadre du management des entreprises sous le nom de « théorie de la (bonne) gouvernance ».

Rhétorique de la gouvernance, médiocratie et extrême-centre

Le philosophe Alain Deneault [11] a effectué un remarquable travail d’analyse des techniques manipulatoires modernes issues des travaux états-uniens menés dans les années 1970 sur le management des entreprises.

Après l’échec des techniques de management scientifique des grandes entreprises de l’après-guerre, les théoriciens de l’organisation se sont inspirés de la rhétorique théologique afin de construire un nouveau modèle de domination.

Une théologie de l’entreprise fut alors élaborée suivant trois axes :

. une religion de la marque

. un personnel censé accorder une foi sans réserve dans l’activité de l’entreprise

. un communautarisme d’entreprise incluant ses clients « consommateurs croyants »

La mise en place de cette religion fut associée à une casuistique manipulatoire appelée « gouvernance » basée sur des termes creux mais à connotations laudatives : excellence, innovation, progrès, efficience, etc…

Cette rhétorique lénifiante n’a en réalité d’autre but que de détourner l’attention du seul véritable objectif de l’entreprise qui est de tout donner à l’actionnaire (oligarchie) et de ne laisser que la part congrue au salarié selon un mécanisme bien expliqué par Paul Jorion. Le salarié est alors invité à laisser -s’il en possède- sa réflexion au vestiaire et à endosser l’habit du médiocre, qui signifie littéralement « dans la moyenne ».

Le médiocre ne sera donc ni brillant ni totalement incompétent d’où le choix par Alain Deneault du terme « médiocratie ».

Cette manipulation « incite » le collaborateur de l’entreprise à adhérer à la religion, ou du moins à faire semblant, sous peine d’excommunication se traduisant par un licenciement !

En face des ces pratiques, Alain Deneault a identifié cinq typologie comportementales.

On trouve d’abord le « cassé », incapable de s’intégrer au système et qui mène donc une existence précaire.

Vient ensuite le « médiocre par défaut » qui croit naïvement aux mensonges dispensés.

Le pire des profil est appelé « médiocre zélé », c’est une véritable plaie (sic) qui marche totalement dans le système dans le but d’en obtenir quelques faveurs, ce dernier possède en outre la capacité de reconnaitre immédiatement ses semblables pour se constituer en meutes de « petits chefs ».

La quatrième typologie concerne le « médiocre malgré lui » qui n’est pas dupe mais qui doit cependant se nourrir et survit tant bien que mal dans un contexte délétère parfois à coup d’antidépresseurs !

En dernier, on trouve le « rebelle », la tête brulée qui dénonce et qui peut au final être récupéré par le système sous la forme d’une star.

Cette nouvelle forme de religion, parfaitement aliénante au sens orwellien du terme, a donc envahi dans un premier temps le champ de l’entreprise.

L’oligarchie ayant quasiment pris le contrôle de tous les pouvoirs politiques et médiatiques, elle n’eut donc qu’à adapter le discours de la gouvernance à son usage pour le déverser à travers ces derniers.

On observe donc une rhétorique apodictique avec ajout de quelques mots clés pour couvrir les champs politiques, économiques et médiatiques : progrès, réformes, privatisations, croissance, modernité, mondialisation heureuse, vérité, réalité…..

On retrouve donc dans les discours politiques alignés et dans les médias associés la même rhétorique Potemkine que dans le bla bla de la communication des entreprises.

Les typologies précitées se retrouvent peu ou prou dans les champs politiques et médiatiques avec un système opérationnel de contrôle suivant plusieurs axes.

Des techniques de contrôle éprouvées

Il n’a évidemment pas échappé à l’oligarchie que la MSM est un fantastique outil de formatage en masse des cerveaux, leur prise de contrôle fut des plus simples puisqu’il a suffit de les racheter progressivement en quasi totalité.

Les oligarques ont alors juré la main sur le cœur qu’ils n’intervenaient en aucun cas dans les lignes éditoriales, ce pseudo débat a été définitivement tranché par Aude Lancelin, insider involontaire, qui a dénoncé en détail ce qu’elle a vécu durant ses 15 années dans la MSM [12].

Pour la presse écrite, l’hémorragie de lecteurs due à une propagande devenant trop visible fut partiellement compensée par les scandaleuses subventions de l’état.

Paradoxe de cette même presse croupion qui éructe à longueur de temps sur les assistés en oubliant que si elle ne l’était pas elle même, alors elle aurait disparu depuis longtemps.

La situation actuelle est un retour à celle d’avant-guerre, une sorte de progrès inversé.

Pour le cas de la classe politique, la prise de contrôle n’est cependant pas totale.

L’oligarchie agit principalement à travers un lobbying très efficace à l’instar de celui qu’a décrit Philippe De Villiers au sein du parlement Européen (Interview ici). Ce dernier nous explique que les transnationales investissent environ trois milliards annuels pour financer une armée de plus de 30 000 lobbyistes destinés à contrôler les eurodéputés et autres bureaucrates qui établissent les législations rédigées directement par les multinationales.

Une anecdote frappante concerne le classement des eurodéputés selon trois catégories, on distingue d’abord les jaunes qui sont les députés abordables et donc « compréhensifs », viennent ensuite les rouges dans la catégorie récalcitrants et enfin les gris « à démarcher avec doigté ».

Les députés « jaunes » voient leur avenir post-mandat assuré avec en récompense pour services rendus des postes à hauts salaires dans un grand groupe privé, ces derniers peuvent même ensuite revenir en politique pour un nouveau cycle, on nomme ce système d’aller-retour public-privé des revolving doors.

Coté bloc BAO, les atlantistes tentent de pérenniser le futur de leur idéologie en construisent des ponts entre les deux rives avec des programmes tels que les Young Leaders (France-USA) avec sa branche Italienne.

Lorsque l’oligarchie propulse ses champions au pouvoir suprême

Les partis traditionnels ayant épuisé leur crédibilité, des mouvements présentés comme nouveaux, jeunes et dynamiques sont apparus (En Marche). Ces derniers surfent en fait sur une pensée unique réactionnaire à l’identique de celle de ses prédécesseurs, seule la façade change.

En effet ceux qui représentent en particulier la vraie gauche comme la France Insoumise sont qualifiés de partis extrémistes, d’autres sont traités de complotistes comme l’UPR de François Asselineau ostracisé par les médias malgré les obligations légales du CSA.

Le cas du Front national est spécifique car ce parti dénoncé comme xénophobe par ses adversaires a subit durant la période Marine Le Pen une cure de dédiabolisation en particulier sous l’influence de Florian Philippot se réclamant proche des idées de Jean-Pierre Chevènement.

Aujourd’hui, le parti LREM de Macron construit de toutes pièces pour gagner les élections avec le soutien total du bras armé médiatique de l’oligarchie est typiquement un parti qui communique avec un discours de l’extrême centre [11].

Emmanuel Macron est un profil typique issu des grandes écoles françaises, il ne possède pas de pensée personnelle et ne sait qu’appliquer des consignes venues d’autorités supérieures. Le régime Macron est donc 100% favorable à ses sponsors comme on le constate dans les faits.

Coté économie, il applique la politique dictée par l’Union Européenne (GOPE), et pour les affaires étrangères il suit une « politique Daladier » et virevoltante calquée sur celle des anglo-saxons en particulier des USA.

Selon ses thuriféraires, sa communication absconse est l’illustration d’une « pensée complexe », d’autres analystes (probablement mauvaises langues !) parlent plutôt de logorrhée.

Ce contexte d’une oligarchie occidentale dominante et internationalisée explique pourquoi l’on constate dans les principaux pays occidentaux un florilège d’imposteurs au pouvoir qui vont du fou dangereux (W. Bush, Sarkozy) au parfait crétin (Hollande) en passant par le bavard médiocre (Macron).

On fait quoi maintenant ?

La lutte pour le pouvoir entre des classes dominantes minoritaires et des classes dominées majoritaires est vieille comme le monde.

Depuis 1789, plusieurs révolutions ont eu lieu en France où une partie de la légitime souveraineté du peuple fut acquise grâce à l’avènement de la République associée au pouvoir des urnes.

Aujourd’hui, le balancier penche une fois de plus en faveur de l’oligarchie avec en parallèle une lutte d’arrière garde de la dernière puissance impériale pour empêcher l’avènement d’un monde multipolaire.

Les gouvernements d’Europe de l’ouest, en particulier de la France qui avait résisté jusqu’à la fin du XXe siècle, ont choisit le mauvais camp qui est celui de la vassalisation à une puissance en déclin.

Pour ceux qui rêvent d’une nouvelle révolution violente, rappelons que ce type d’action est parfaitement inutile s’il n’existe pas un système de rechange intelligemment construit pour prendre le relais. Citons Soljenitsyne qui a rappelé les leçons de l’histoire avec des révolutions qui finissent souvent très mal comme celle de Russie avec 70 ans de totalitarisme et des millions de morts.

Le visionnaire Orwell avait parfaitement anticipé un principe de novlangue aujourd’hui appliqué quotidiennement par nos élites au pouvoir : « l’ignorance c’est la force ».

La véritable révolution consiste donc bien à casser ce mécanisme et à faire prendre massivement conscience de la situation réelle à la population. La première étape est de cesser de croire à la propagande médiatique, la seconde de faire usage de son droit de vote à bon escient pour reprendre sa souveraineté.

Cependant, éjecter cette coterie ne suffira pas s’il n’existe pas une alternative crédible à la politique de classe de cette dernière.

Il semblerait bien que cette alternative soit devant nos yeux !

Liens

[1] « Sur la télévision » – Pierre BOURDIEU – 1996

[2] « La Fabrication consentement » – Noam Chomsky

[3] Bras de fer «Coalition occidentale» contre «BRICS/OCS»: Point de situation et perspectives – Général Dominique Delawarde

[4] « Le système peut il s’effondrer ? » – conférence Régis Chamagne 02/2018 ici.

[5] « Le 4ième pouvoir a été racheté ! » – Sur ce site.

[6] « Concentration des médias en France et ailleurs » – site Acrimed

[7] « De Jeanne d’Arc à l’atlantisme européiste, 600 ans de trahisons des élites françaises » – Sur ce site.

[8] « Aux origines du carcan européen » – Annie Lacroix-Riz – 2014

[9] « Guerre Fantôme » – Reportage brillant sur le scandale Alstom

[10] Qui contrôle les médias, contrôle les cerveaux…et les bulletins de vote ! – Sur ce site.

[11] « Médiocratie, Politique de l’extrême centre, Gouvernance » – Alain DENEAULT

[12] « Le monde libre » – « La pensée en otage » – Aude Lancelin

v 1.2 – 3 699 (MAJ 28/05/2018)

Cet article est publié sur Agoravox ici.

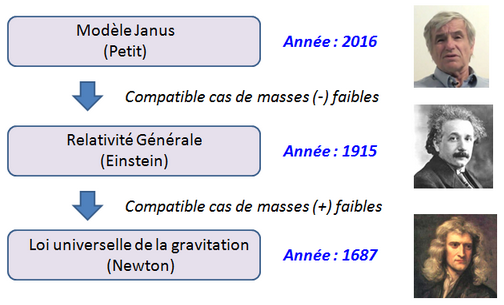

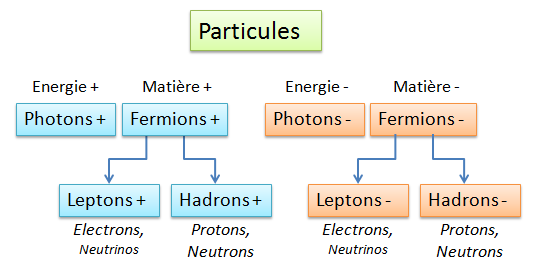

Les 25 particules à masse positive du modèle standard

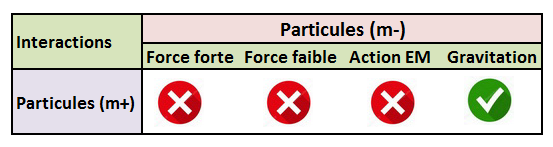

Les 25 particules à masse positive du modèle standard Les particules du modèle standard à masse positive (m+) et leurs interactions possibles

Les particules du modèle standard à masse positive (m+) et leurs interactions possibles

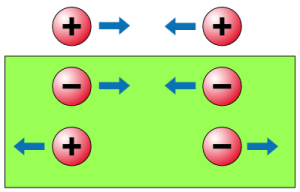

Interactions possibles entre les particules des deux espèces

Interactions possibles entre les particules des deux espèces

Vesto Slipher

Vesto Slipher

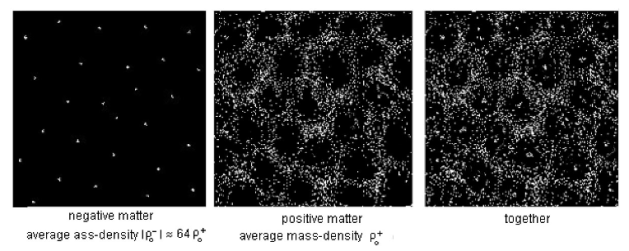

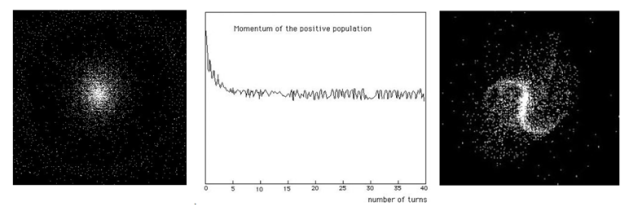

Simulations de 1992 sur 10 000 points masses de matières (+) et (-)

Simulations de 1992 sur 10 000 points masses de matières (+) et (-) Simulation d’une galaxie spirale (droite) à partir d’un nuage de gaz (gauche)

Simulation d’une galaxie spirale (droite) à partir d’un nuage de gaz (gauche) Galaxie NGC 1300

Galaxie NGC 1300